「AIが音楽を変える日」連載第0回

今年、4月半ばのことである。「ゴーストライター」を名乗る、真っ白なシーツを頭から被り、その上からサングラスを掛けた奇怪な男が音楽史に残る曲をTikTokに投稿した。

理由は名曲だったからではない。普通の曲だった。だが、普通であることが話題を攫った。それは「超人気ラッパーのドレイクとザ・ウィークエンドがコラボしたらどんな曲になるか」をAIに命令し、生成した楽曲だったからである。

歌詞もふつうに聴けた。「ザ・ウィークエンドがむかし付き合っていたセレーナ・ゴメスについて歌ったもの」というテーマでAIが作詞したものだ。その曲、「ハート・オン・マイ・スリーヴ」はツイッターに転載され、2000万回も再生された。

ドレイクとザ・ウィークエンドの所属するユニバーサル・ミュージックの要請により、全プラットフォームから当該曲は削除されたが、謎の男「ゴーストライター」がユーチューブに残した「これは始まりにすぎない」というコメントはニュースサイトで拡散していった。

筆者はその1週間前、Boomyという音楽生成AIをチェックしたばかりだった。「画像生成と同じように誰もが音楽の生成を楽しめるようになる」と開発者は語っていたが、「ヒップホップのような単純な構造なら相性もよさそうだが、何百万再生もされる品質には遠いかな」という印象を楽曲群から受けていた。

その矢先のことだった。「ゴーストライター」が予想外の品質に到達していたのは、実在の人気ラッパーの声色と発声法(大規模言語モデルのモーダルに相当か)を使うのみならず、アーティストの経験を扱ったテーマで歌詞を生成していたからなのだろう。

通称〝フェイク・ドレイク〟のブレイクから一週間後、スポティファイが決算説明会を開くことになり、そこで「AIの作った曲が無数にアップロードされてしまったら?」という質問が飛んだ。エクCEOは「たとえばセルフ・カヴァーの生成に使えばアーティストにもプラスになる」とうまく答えた。

実際、同時期、ジャスティン・ビーバーによるマイリー・サイラスのカヴァー曲、マイケル・ジャクソンが歌うロックバンド・サバイバーのカヴァー曲、テイラー・スウィフトがカニエ・ウェストをカヴァー等々、AIが生成したカヴァー曲が次々とTikTokに投稿された。驚くべき品質なので検索して聴いてみてはいかがか。

生成型AIの歴史はネットの歴史をなぞっている。昨年のChatGPTの流行でまずデータの軽いテキスト生成が、すぐに画像生成が実用レベルに到達。今年には間を置くことなく音楽生成へと入り、同時に動画の自動生成も開発が進行中だ。

これはネットの誕生時と比べて進化が速い。1992年にネットで文章と画像を同時に扱えるブラウザが発明され、98年にファイル共有の発明で音楽ファイルがネットを席巻するまで6年以上の歳月が流れた。そこからユーチューブ誕生の2005年まで7年だ。

冷静に見れば〝フェイク・ドレイク〟は、画像生成の世界だと偽の顔写真の生成が高解像となり「ディープフェイク」が日常になった2017年の段階に相当する。そこから人間の顔のみならずあらゆるものを生成できるに至り、現在の驚異的な品質に到達した。音楽生成AIもまた次の段階が待っているということだ。

ここからふたつのことが考えられる。ひとつめは、画像生成のように音楽生成AIで誰もが音楽を作る楽しみを知るようになることだ。それは人を感動させる名曲を作れるか、というのとは別の感動である。

画像生成が顔だけから守備範囲を広げていったように、音楽生成AIはいずれヒップホップの他に様々な得意ジャンルを持つことになるだろう。

そしてAIによるカヴァーの品質が高いことから、ふたつめの予測が立つ。「攻殻機動隊」に人格をAIにコピーするエピソードがあるが、同じことが音楽の世界で起こる。アーティストの声や歌唱法、演奏の癖をAIにコピーして売る時代になるだろう。

そのAIはひとつの曲をライブ演奏のように様々な形で歌い上げる。セルフ・カヴァーは言うを俟たず、今は亡きマイケル・ジャクソンとコラボするなど、実際には不可能なフィーチャリング・ソングを生成して楽しめるようにもなるだろう。

それはレコードの発明以来の大転換を音楽産業にもたらすかもしれない。エジソン以来、音楽産業はミュージシャンの演奏をスタジオで原盤に収め、それをレコードやCDに複製して音楽ファンに届けてきた。ひとつの演奏のコピーを繰り返し聴くのは、サブスク時代でも変わらなかったがAIがこの時代を終わらせると2年前、拙著でも予言した。

アーティストの歌唱法や演奏法をAIにコピーできるとしても、作詞作曲のセンスまでコピーできるか、といえばそれは分からない。意味を理解しない現在の「弱いAI」は、それっぽいものは出来ても人の心を動かす新曲までは無理だと思う。

しかし、プロットや書き出しの霊感を得るためにAIを使う小説家がいると読んだことがある。ミュージシャンもAIを作詞作曲のサポートに活用するようになるだろう。少なくとも手癖での作曲の弊を免れることができる。

何よりも期待しているのは「楽器としてのAI」だ。

エレクトロニクスの誕生でエレキギターが発明され、R&Bやロックが生まれた。半導体の進化でサンプラーが生まれ、ヒップホップの基になった。21世紀でもPCの進化でDTMのプラグインを駆使するEDMが生まれている。振り返ればクラシックも、ピアノやヴァイオリンの発明があったからこそだ。

このように新しい技術は新しい音楽ジャンルを生み、メガトレンドを音楽産業にもたらしてきた。だが、これまでITはエポックメイキングな新しい楽器を生み出してこなかった。

音楽でのAIの活用はサブスクでの楽曲のキュレーション、すなわちレコメンデーションエンジンに限られてきた。グーグルのような検索エンジンもネットから情報をキュレーションするAIなので、音楽もネットと進化を共にしてきたといえる。そしてAIは情報のキュレーションの時代からコンテンツの生成へと向かっている。

生成型AIのプロンプトはテキストベースであり、それも楽器のUIとして斬新だが、もっと楽器的に優れたUIが発明されたなら、AIはクラシックやロック、ダンスミュージックに続く新しい音楽ジャンルをこの星にもたらすことになるだろう。

(文:榎本幹朗)

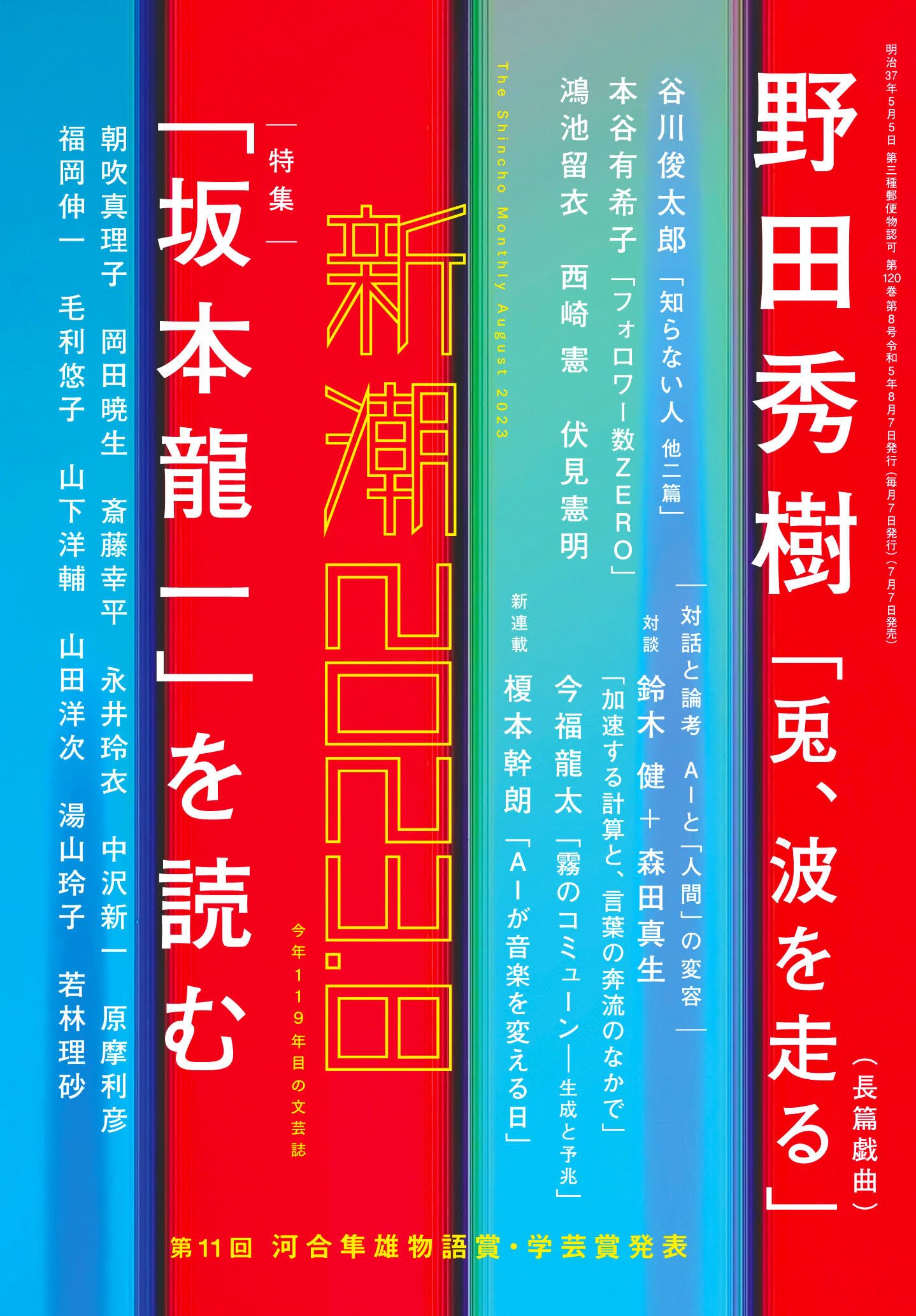

※「AIが音楽を変える日」は現在『新潮』(本日7月

著者プロフィール

榎本幹朗(えのもと・みきろう)

榎本幹朗(えのもと・みきろう)

1974年東京生。作家・音楽産業を専門とするコンサルタント。上智大学に在学中から仕事を始め、草創期のライヴ・ストリーミング番組のディレクターとなる。ぴあに転職後、音楽配信の専門家として独立。2017年まで京都精華大学講師。寄稿先はWIRED、文藝春秋、週刊ダイヤモンド、プレジデントなど。朝日新聞、ブルームバーグに取材協力。NHK、テレビ朝日、日本テレビにゲスト出演。現在『新潮』にて「AIが音楽を変える日」を連載中。

ポッドキャスト概要:

Musicman Podcast — 業界の“今”を深掘り

「Musicman大学」は世界の音楽業界の最新トピックスを解説。講師は『音楽が未来を連れてくる』の著者、Musicman編集長・榎本幹朗。「Talk&Songs」は月間500組ものアーティストニュースを担当するKentaが選ぶ、今聴くべき楽曲と業界人必聴のバズった曲を解説。

Spotifyでポッドキャストを聴くプレイリスト概要:

記事連動セレクション — エピソードと繋がる楽曲たち

月間500のアーティスト記事から厳選した楽曲と、業界人必聴のバズ曲をプレイリストで。最新シーンの決定版!

Spotifyでプレイリストを聴く@musicman_nusicman

広告・取材掲載